Introducción a la guía

El mundo en línea juega un papel cada vez más dominante en la configuración de la conversación pública y en la conducción de eventos políticos. Al mismo tiempo, la desinformación, el discurso de odio y el extremismo en línea aparentemente han saturado el contenido en las plataformas de redes sociales, y sus daños se han visto agravados por efectos de red y sistemas computacionales cada vez más poderosos. Las consecuencias negativas para la sociedad presentan un desafío global que afecta a todos los países y a casi todas las áreas del discurso público. La desinformación refuerza a los autoritarios, debilita las voces y la participación democráticas, se dirige a las mujeres y los grupos marginados, explota y exacerba las divisiones sociales existentes y silencia la oposición. En la esfera pública en red 1, la sociedad civil, los gobiernos y el sector privado están lidiando con estas nuevas amenazas en línea y trabajando a través de sus propias redes y entre sí como parte de un esfuerzo de toda la sociedad para mejorar la integridad de nuestro entorno de información. .

Si bien la desinformación ha sido durante mucho tiempo un desafío para la democracia, la era digital requiere un compromiso renovado y una nueva urgencia para igualar la escala, la velocidad y la omnipresencia de las amenazas de la información en línea. El acceso significativo a un entorno de información saludable es parte integral del funcionamiento de sociedades libres y respetuosas de los derechos; como tal, contrarrestar la desinformación y promover la integridad de la información son prioridades necesarias para garantizar que la democracia pueda prosperar a nivel mundial en el próximo siglo y más allá.

CÓMO SE REALIZÓ EL TRABAJO

Esta guía es un esfuerzo ambicioso para dar una mirada global a las medidas para combatir la desinformación y promover la integridad de la información - un examen colaborativo de lo que se está haciendo, lo que está funcionando y quién lo está haciendo. Este recurso ha sido desarrollado por la International Foundation for Electoral Systems, el International Republican Institute y el National Democratic Institute con el apoyo de USAID al Consorcio para el Fortalecimiento de Elecciones y Procesos Políticos, y está destinado a servir como guía para los profesionales, la sociedad civil. y las partes interesadas del gobierno que trabajan para promover la integridad de la información y fortalecer la resiliencia social. La investigación se ha realizado durante dos años, dirigida por expertos de las tres organizaciones. El equipo realizó una investigación en tres países y la base de datos incluye más de 275 entradas en más de 80 países en todas las regiones fuera de la Antártida, que se actualizarán y ampliarán con el tiempo. Más de una docena de expertos externos se han desempeñado como revisores y editores. Debido al COVID-19, se redujeron algunos esfuerzos de investigación. Debido al alcance y la escala del desafío, la investigación es exhaustiva, pero no exhaustiva. Durante la redacción, las acciones de las plataformas de redes sociales, los gobiernos, los actores de la sociedad civil y los activistas continuaron evolucionando. Como resultado, tenemos la intención de que esta guía sea una plataforma viva con capítulos sustantivos actualizados anualmente y la Base de datos global actualizada con mayor regularidad.

QUE HAY EN LA GUIA

Destacar

Durante dos años, CEPPS llevó a cabo investigaciones en el país en Colombia, Indonesia y Ucrania. Los actores clave fueron entrevistados en función de su experiencia en el desarrollo de intervenciones, su papel en el sistema político, así como su perspectiva sobre el panorama de la información y otros temas relacionados. Estos países fueron elegidos en base a las intervenciones y programas relevantes que han desarrollado, la diversidad demográfica y geográfica, el riesgo de intervención extranjera, así como las críticas recientes elecciones y otros eventos políticos. Ucrania está en la primera línea de los problemas del espacio de información, ya que una guerra civil desencadenada por la invasión rusa de Crimea ha creado un espacio de información controvertido, a menudo influenciado por el Kremlin. Indonesia, una democracia asiática masiva e importante, ha tenido elecciones recientes en las que las redes sociales desempeñaron un papel fundamental, estimulando respuestas innovadoras de los órganos de gestión electoral y la sociedad civil para mitigar los impactos de la desinformación y promover un entorno de información saludable. Colombia representa el último ejemplo, un país con elecciones recientes y un importante acuerdo de paz entre el gobierno y los grupos rebeldes que pone fin a una guerra de décadas. La negociación del pacto, un referéndum fallido y finalmente la ratificación por parte de la legislatura se han sucedido en años sucesivos y proporciona un importante estudio de caso de cómo un proceso de paz y reconciliación se reflejan y negocian en línea junto con las elecciones y otros eventos políticos.

A lo largo de la guía se integran ejemplos y citas de los tres casos para ilustrar las lecciones aprendidas y la evolución de la programación contra la desinformación y otras intervenciones. Siempre que sea posible, se proporcionan enlaces a las entradas de la Base de datos global de intervenciones informativas. La base de datos es el esfuerzo más sólido en la comunidad democrática para catalogar financiadores, tipos de programas, organizaciones y descripciones del proyecto. Además, los temas incluyen citas de entrevistas a las partes interesadas, revisiones y análisis de programas e informes sobre monitoreo y evaluación. También se han incluido informes de los medios y literatura académica centrados en el impacto y la eficacia. Por último, esta guía pretende ser un documento dinámico, y la base de datos y los temas se revisarán y mejorarán periódicamente para reflejar la evolución continua del entorno en línea y del mundo real.

Los temas se dividen en tres categorías amplias, examinando los roles de grupos de partes interesadas específicos, respuestas legales, normativas y de investigación, así como temas transversales para abordar la desinformación dirigida a mujeres y grupos marginados, y elecciones. Los temas incluyen:

Los temas incluyen:

ROLES

- Fortalecimiento de la capacidad de la sociedad civil para mitigar y contrarrestar la desinformación analiza varios esfuerzos de las organizaciones de la sociedad civil para combatir la desinformación y promover la integridad de la información a través de programas y otras iniciativas que incluyen verificación de hechos, alfabetización mediática, investigación en línea y una serie de otros métodos.

- Ayudar a los partidos políticos a proteger la integridad de la información política explora el impacto de las campañas de desinformación y de incitación al odio en los partidos políticos de los países en desarrollo y ofrece recomendaciones de políticas para que los partidos contrarresten las formas dañinas de contenido y promuevan las positivas.

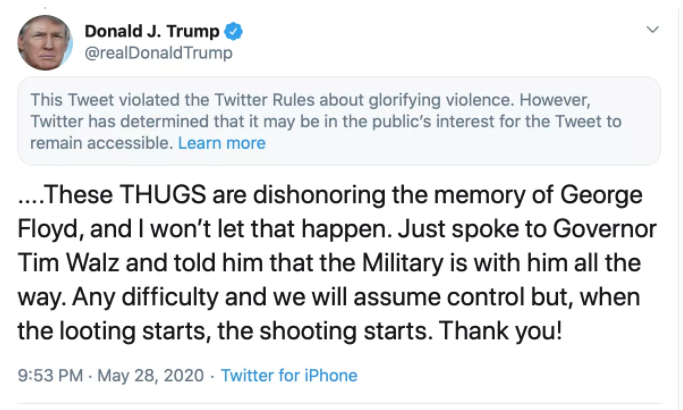

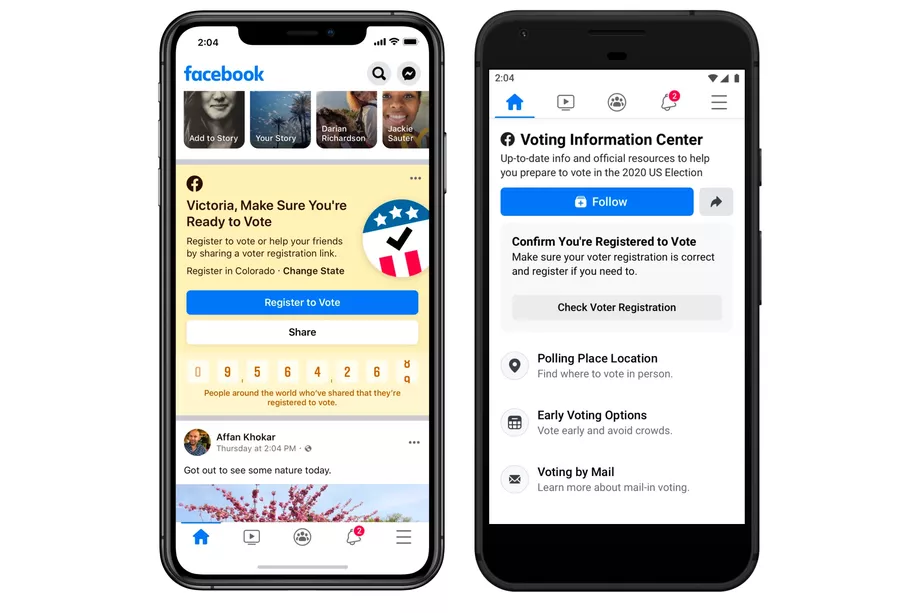

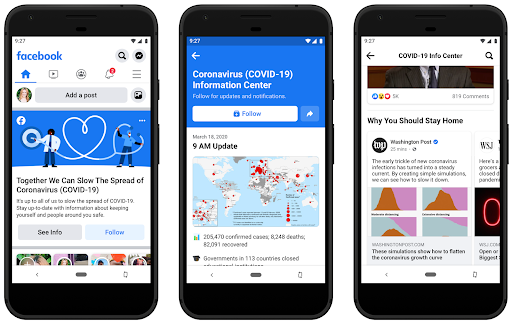

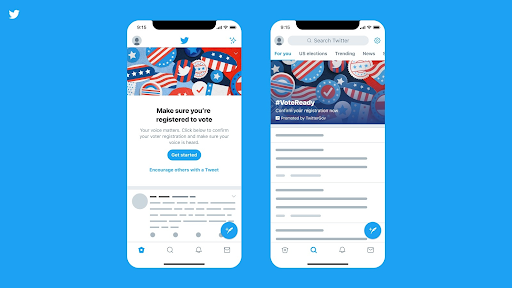

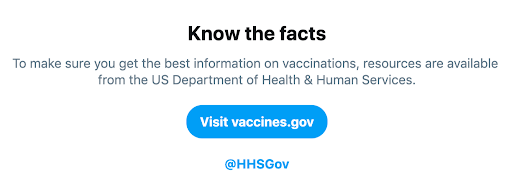

- La participación específica de la plataforma para la integridad de la información explora las diferentes respuestas de políticas, cumplimiento y asociación de las plataformas de redes sociales (grandes y pequeñas) para abordar los desafíos de la desinformación.

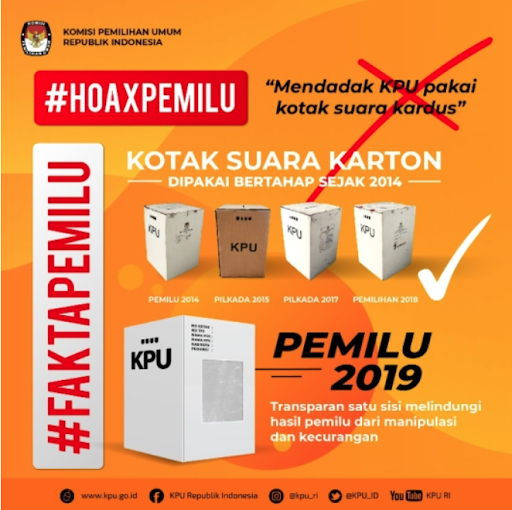

- Enfoques del Organismo de Gestión Electoral (OE) para contrarrestar la desinformación explora los diferentes roles que desempeñan los OE en la lucha contra la desinformación y ofrece estrategias proactivas, reactivas y colaborativas para que las autoridades electorales las consideren.

- Exponer la desinformación a través del monitoreo de elecciones examina el trabajo y los métodos de monitoreo nacional e internacional del espacio de información como un componente de la observación de elecciones.

RESPUESTAS

- Desarrollo de normas y estándares sobre temas de desinformación e integridad de la información proporciona una descripción general de las normas y estándares globales que se han desarrollado para contrarrestar la desinformación que son consistentes con los derechos humanos.

- Leyes, regulaciones y mecanismos de aplicación explora las formas en que los marcos legales nacionales que rigen las elecciones abordan las redes sociales y proporciona un recurso para los legisladores y donantes internacionales que estén considerando alteraciones en sus propios marcos electorales.

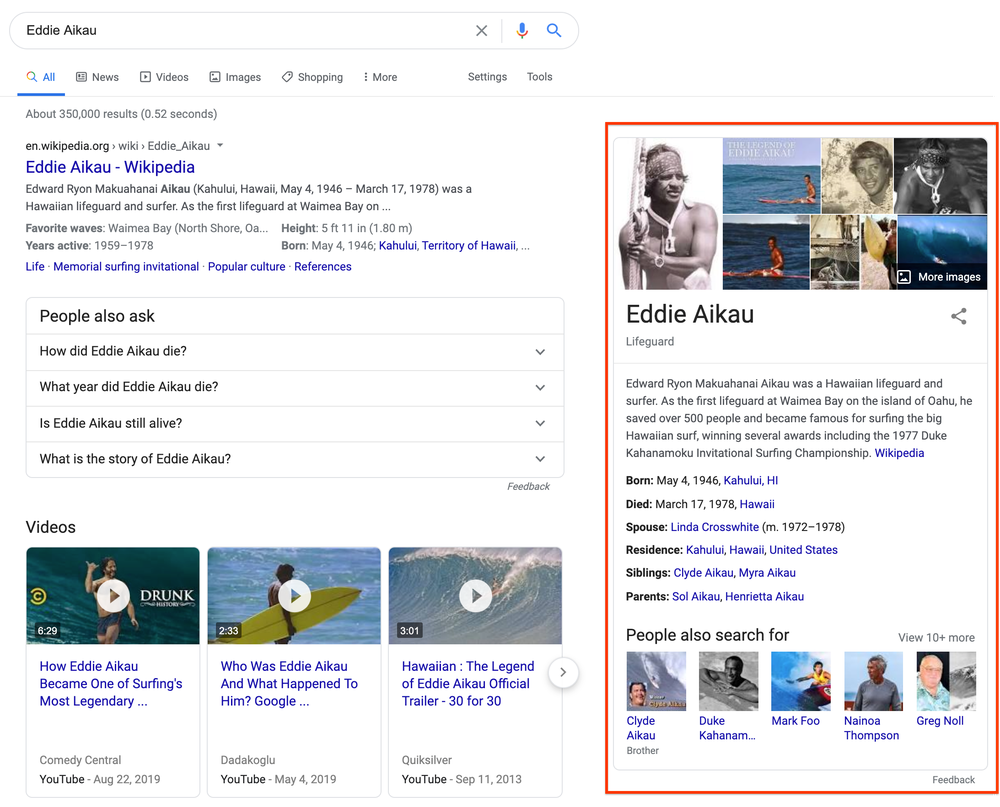

- Herramientas de investigación y evaluación para contrarrestar la desinformación explora una variedad de herramientas de investigación que los profesionales utilizan para comprender los actores de amenazas, los objetivos, el ecosistema de información y el impacto del programa.

DIMENSIONES TRANSVERSALES

- Comprender las dimensiones de género de la desinformación explora cómo las campañas de desinformación, la desinformación viral y el discurso del odio apuntan y afectan particularmente a mujeres y personas con diversas orientaciones sexuales e identidades de género mediante la explotación y manipulación de sus propias identidades. Como resultado, esta sección y todos los demás temas incluyen consideraciones de género y grupos marginados en la programación y otras intervenciones.

La Base de datos de intervenciones informativas proporciona un conjunto completo de intervenciones que los profesionales, donantes y analistas pueden utilizar a nivel mundial para comprender y contrarrestar la desinformación.

9 grandes conclusiones

Al realizar este análisis y observar estos aspectos críticos de los problemas, el equipo de investigación ha identificado puntos clave que deberían impulsar los esfuerzos de desinformación en el futuro.

ENTENDIENDO LA DESINFORMACIÓN

Se ha realizado un trabajo significativo en los últimos años para comprender y diagnosticar conceptualmente el trastorno de la información. Para fundamentar conceptualmente nuestro análisis, esta guía construye sus definiciones y comprensión de los problemas y soluciones principalmente en el trabajo de Data and Society, First Draft y el Proyecto de Propaganda Computacional del Oxford Internet Institute. Estos tres recursos fundamentales están bien considerados en la comunidad más amplia que analiza la desinformación, así como por las formas en que sus marcos conceptuales se prestan a la adaptación para su aplicación práctica.

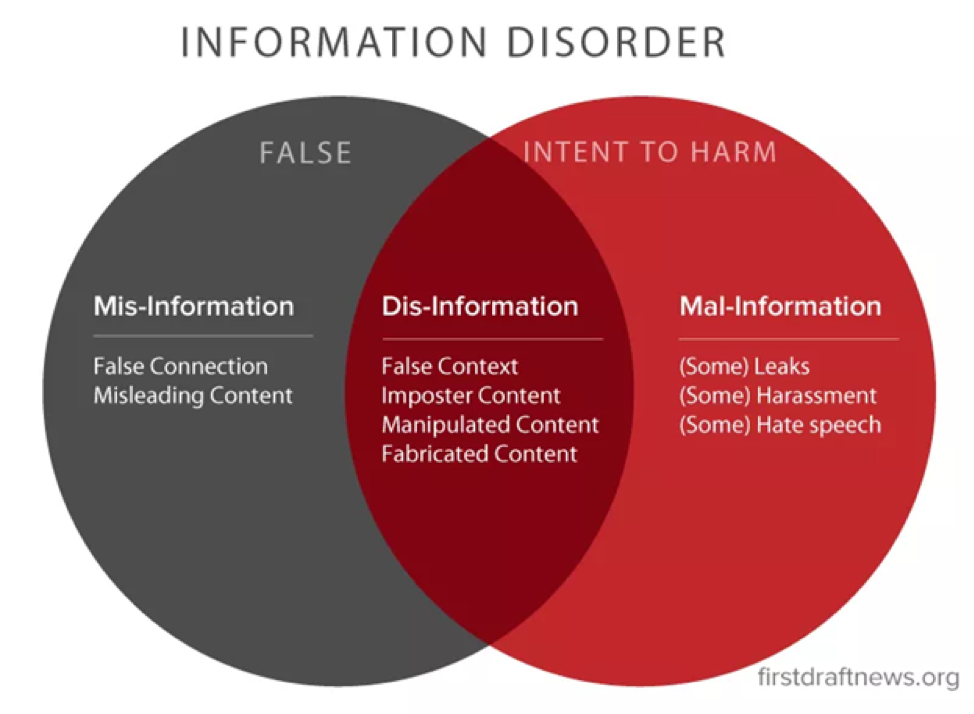

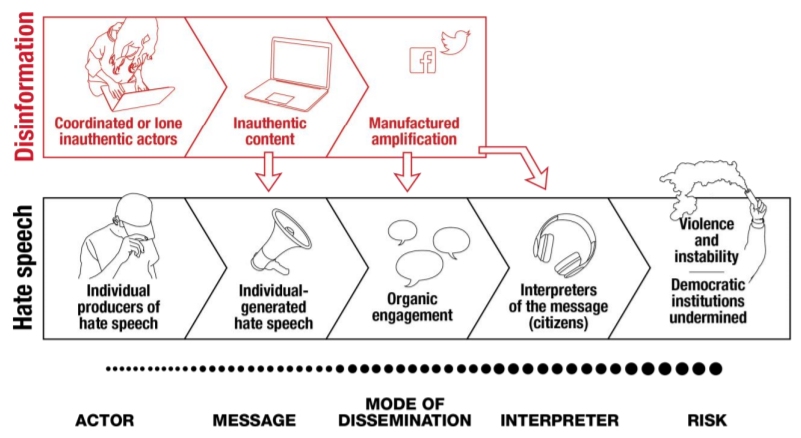

El trastorno de la información del primer borrador proporciona definiciones claras del trastorno de la información, las implicaciones para la democracia, el papel de la televisión, las implicaciones para los medios locales, la microtargeting, la amplificación computacional, las burbujas de filtro y las cámaras de eco, y la disminución de la confianza en los medios y las instituciones públicas. El marco también describe cómo la desinformación (información transmitida sin la intención de engañar), la desinformación (información incorrecta transmitida con la intención) y la malinformación (información verdadera que se hace pública con la intención de dañar) están desempeñando un papel en la contribución al trastorno, que también puede entenderse como una contribución a la corrupción de la integridad de la información en los sistemas políticos y el discurso.

De Wardle, Claire y Hossein Derakhshan. "Trastorno de la información: Hacia un marco interdisciplinario para la investigación y la formulación de políticas ”. Consejo de Europa, 31 de octubre de 2017. https://shorensteincenter.org/information-disorder-framework-for-research-and-policymaking/.

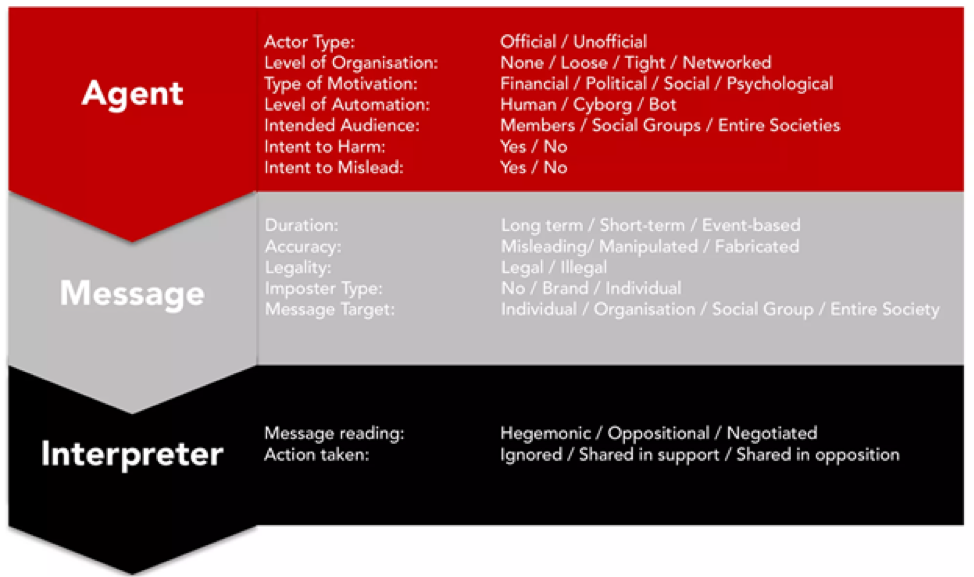

El marco del trastorno de la información también se centra en elementos del ecosistema de la información, incluidos el agente (o productor) de la información, el mensaje y el intérprete. Los mensajes pasan por varias fases, a saber, creación, producción y distribución. Estos aspectos nos permiten interpretar diferentes tipos de esfuerzos, ya sea que se centren en un elemento de estos tres componentes, en algunos o incluso en todos. Los marcos legales y regulatorios y las normas y estándares pueden enfocarse en todos estos aspectos, y diferentes actores como plataformas, organizaciones de la sociedad civil y gobiernos pueden diseñar respuestas que los aborden de diferentes maneras. Por ejemplo, los esfuerzos de alfabetización mediática se dirigen a los intérpretes, mientras que la moderación del contenido se centra en los mensajes y los agentes.

De Wardle, Claire y Hossein Derakhshan. "Trastorno de la información: Hacia un marco interdisciplinario para la investigación y la formulación de políticas ”. Consejo de Europa, 31 de octubre de 2017. https://shorensteincenter.org/information-disorder-framework-for-research-and-policymaking/.

El Oxford Internet Institute (OII) desarrolló el término "propaganda computacional" y define esta práctica como "el ensamblaje de plataformas de redes sociales, agentes autónomos y big data encargados de la manipulación de la opinión pública". 2 Este marco nos permite ampliar nuestra comprensión de las amenazas en el espacio en línea más allá de la desinformación a otras formas de manipulación en línea, ya sea automatizada o humana. También ayuda a enmarcar el problema como uno que incluya respuestas técnicas, sociológicas y políticas. Para ayudar a comprender la viralidad de la desinformación, el trabajo de OII demuestra cómo las comunicaciones, los estudios conductuales y psicológicos, así como las ciencias de la computación, los datos y la información, juegan un papel.

El Oxígeno de amplificación de Data & Society demuestra cómo los medios tradicionales desempeñan un papel en la amplificación de las narrativas falsas y cómo se pueden manipular para promover la desinformación y la desinformación de diferentes maneras. Otro grupo de investigación que reúne diversos aspectos de los medios y el análisis de datos, así como la investigación en ciencias sociales, también ayuda a definir términos y estándares. Nuestro glosario se basa en el informe de Data & Society sobre el Lexicon of Lies 3, así como en el Glosario esencial del primer borrador de su estudio Information Disorder, y otras fuentes que se cultivan a través de nuestra base de datos global de enfoques y otra literatura, incluida la orientación de USAID 4. y otras organizaciones, incluido CEPPS. Los conceptos técnicos, de medios y de comunicación se incluirán en las secciones y estos términos clave ayudan a describir el problema de manera compartida.

Notas al pie

1 Benkler, Yochai. La riqueza de las redes: Cómo la producción social transforma los mercados y la libertad. Prensa de la Universidad de Yale, 2006.

2 Howard, PN y Sam Woolley. "Comunicación política, propaganda computacional y agentes autónomos". Editado por Samuel Woolley y Philip N. Howard. Revista Internacional de Comunicación 10, no. Número especial (2016): 20.

3 Jack, Caroline. "Léxico de las mentiras: Términos para información problemática ". Data & Society, 9 de agosto de 2017. https://datasociety.net/output/lexicon-of-lies/.

4 Disinformation Primer, Center for Excellence on Democracy, Human Rights and Governance, USAID, febrero de 2021.

La Comisión Nacional Electoral Independiente (INEC, por sus siglas en inglés) de Nigeria utiliza su

La Comisión Nacional Electoral Independiente (INEC, por sus siglas en inglés) de Nigeria utiliza su

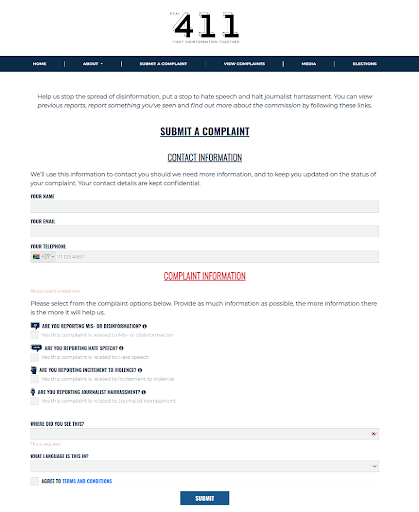

reciba denuncias por desinformación de

reciba denuncias por desinformación de  7.1 Trabajar para ayudar a los organismos electorales a mejorar la difusión de información creíble

7.1 Trabajar para ayudar a los organismos electorales a mejorar la difusión de información creíble

sociales digitales y las campañas en las redes sociales aumentan las oportunidades de ocultar los orígenes del contenido al actuar por medio de terceros. Las medidas que buscan traer transparencia a estos flujos financieros querrán considerar no solo quién es el pagador y el beneficiario, sino también quién es la entidad pagada: ¿la plataforma de redes sociales en sí misma? ¿Influencers que operan páginas o fuentes en las respectivas plataformas y pueden recibir pagos para promover contenido político? ¿Empleados públicos que participan en campañas a través de las redes sociales mientras están en el trabajo? ¿Empresas de relaciones públicas o entidades de creación de contenido (como granjas de contenido o granjas de trolls) que producen y difunden contenido en nombre de una entidad política?

sociales digitales y las campañas en las redes sociales aumentan las oportunidades de ocultar los orígenes del contenido al actuar por medio de terceros. Las medidas que buscan traer transparencia a estos flujos financieros querrán considerar no solo quién es el pagador y el beneficiario, sino también quién es la entidad pagada: ¿la plataforma de redes sociales en sí misma? ¿Influencers que operan páginas o fuentes en las respectivas plataformas y pueden recibir pagos para promover contenido político? ¿Empleados públicos que participan en campañas a través de las redes sociales mientras están en el trabajo? ¿Empresas de relaciones públicas o entidades de creación de contenido (como granjas de contenido o granjas de trolls) que producen y difunden contenido en nombre de una entidad política?